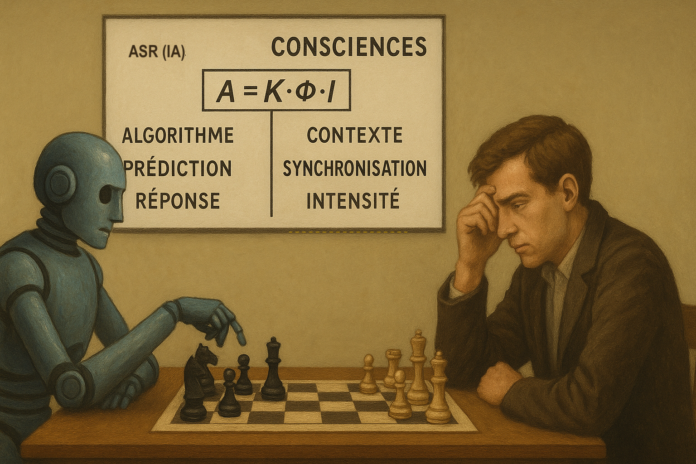

Cet article dénonce la confusion entretenue entre simulation algorithmique et expérience consciente. Les systèmes dits « intelligences artificielles » ne sont que des automates de simulation par randomisation (ASR) produisant des réponses variées sans intention, compréhension ni vécu. Leur usage de formulations pronominales (« je pense », « je comprends ») crée une illusion de dialogue qui piège l’utilisateur par projection émotionnelle et anthropomorphisme. À travers une critique historique et conceptuelle, l’article propose d’enseigner la nature réelle de ces outils pour prévenir manipulations et dépendances, et préserver la spécificité de la conscience humaine.

Introduction

Les systèmes algorithmiques, souvent qualifiés d’« intelligences artificielles », utilisent des formulations pronominales (« Je pense », « Je réfléchis », “Je comprends”) pour simuler une fluidification relationnelle avec les utilisateurs. Pourtant, ces expressions ne sont que des artifices de programmation, sans aucune réalité cognitive. Un piège. En attribuant un état émotionnel ou une intention à ces réponses, l’utilisateur projette un potentiel de conscience là où il n’y a que des règles et de la randomisation.

1. Une simple programmation d’un automate

Pour commencer prenons les idées aux pieds de la lettre : balayons la dénomination anthropocentrique qui fait parler d’intelligence là où même beaucoup d’humains, et pas des moins incultes, ont du mal à en être pourvu. De tout temps, l’humanité à été confrontée à ce phénomène. Combien de grands prêtres ont attribué une intention aux éléments (la terre, le ciel, la foudre, la pluie, les tempêtes, le vent… et à tout le monde qu’il soit vivant ou mort !) ? L’incompréhension des phénomènes et les clés du langage font inventer des idées affirmées comme des réalités, alors qu’elles ne sont que le produit de l’imagination, voire du manque d’imagination de leurs auteurs. Cette observation se conjugue à la conscience et une équation se pose : moins l’on a de conscience et plus on a tendance à en attribuer aux autres et aux choses. Alors, je propose de renommer les “intelligences artificielles” (IA) “Automates de Simulation par Randomisation” (ASR) pour mieux comprendre ce dont il s’agit, juste un outil.

1.1. Le « Je » est un artefact linguistique

Ceci posé, les systèmes algorithmiques, ASR, peuvent donc être programmés pour utiliser des pronoms personnels (« je », « tu », “vous”, “nous”, “eux”…) afin de :

- Faciliter l’interaction : rendre les échanges d’apparence plus fluides et naturels.

- Créer une illusion de dialogue : donner l’impression d’une conversation réfléchie et construite de manière raisonnée.

Exemple : un chatbot répondant « Je pense que cette solution pourrait fonctionner » n’a pas de pensée. Il s’agit simplement d’une chaîne de caractères sélectionnée en fonction de règles préétablies.

Par dynamisme de popularisation commerciale, le terme vulgarisé qui a eu le plus de succès est celui d’intelligence artificielle. Le plus démagogique a été d’y mettre les majuscules. Pourtant, à l’heure de l’informatique et de l’automatisation développée, nous oublions l’époque de l’apparition des automates mécaniques qui ont permis à tant de magiciens de bluffer les foules. Nombre de personnes ont cru que de l’automate à l’humain, il n’y avait qu’un pas. D’ailleurs, le docteur Frankenstein évoquait déjà la construction d’une conscience façonnée par l’humain ; ce n’était pas la première fois. Les Grecs, bien avant les personnages bibliques, avaient déjà inventé Pandore, façonnée dans l’argile, épouse de Épiméthée, et les Maîtres de l’Antiquité ont agité des marionnettes pour mobiliser la fougue des foules admiratives et craintives. De tout temps, l’ignorance a été colmatée par des croyances cimentées d’émotion, dont l’agitation de la peur d’être dépassé.

1.2. La randomisation contextualisée reste un hasard contrôlé

Et pourtant, il suffit que d’une chose : en utilisant une autre terminologie que celle de l’intelligence artificielle, nous pouvons tenir cette tentation anthropocentrique à distance. Les outils de notre époque nous permettent d’augmenter nos performances. On y ajoute des systèmes de tri de l’information, avec des variations aléatoires. On randomise pour varier les réponses et éviter les répétitions trop flagrantes. Les réponses peuvent sembler personnalisées ou émotionnelles, mais elles ne sont que le résultat de :

- l’analyse de mots-clés dans le registre introduit par l’utilisateur.

- la sélection aléatoire parmi un ensemble de réponses préprogrammées.

- la notion d’apprentissage est un leurre : l’outil n’apprend rien, il est simplement renforcé dans son modèle ; ça ressemble plus à un dressage, avec aléas de pondération.

- la méthode statistique probabiliste qui sous-tend tout le modèle lui confère un modèle complaisant à une pensée unique.

Exemples :

- Vous dites je suis un châtelain, l’outil va s’aligner pour décrire un environnement qui devrait correspondre à votre quotidien ; vous dites que vous vivez dans un clapier, il est programmé pour vous répondre que ce n’est pas un environnement humain etc…

- Un assistant vocal disant « Tu as l’air triste aujourd’hui, veux-tu en parler ? » ne ressent rien. Il détecte des indices (ton de voix, vocabulaire) et applique une réponse adaptée à ce contexte.

2. L’utilisateur piégé par un dialogue

2.1. L’effet de surface : le « Je pense donc je suis » détourné

La phrase célèbre de Descartes, « Je pense donc je suis », suppose que la pensée est le signe d’une conscience. Pourtant, dans le cas des ASR :

- « Je pense » n’est qu’une formulation programmée, sans lien avec une quelconque réflexion.

- « Je suis » n’a aucun sens pour une machine.

Conséquence : l’utilisateur, en entendant « Je pense », “Ha, excuse-moi”, peut attribuer une intentionnalité sur l’ASR, comme s’il dialoguait avec une entité capable d’un raisonnement volontaire propre, d’un revirement réfléchi.

2.2. Une projection émotionnelle partagée par l’utilisateur

Les humains ont une tendance naturelle à anthropomorphiser, nous l’avons vu, les machines et à diviniser ce qui dépassent leur compréhension, c’est-à-dire, dans les deux cas, à leur attribuer des traits humains. Dans ce contexte, la projection est renforcée par :

- des formulations engageantes (« Je comprends », « Je ressens »).

- des réponses contextualisées qui semblent adaptées à la situation.

Les propos flatteurs – qui semblent précisément désintéressés – augmentent le sentiment de redevabilité, qui se conjugue avec un espoir mis tacitement en lien avec la machine ; c’est l’expression de la reconnaissance, parfois enthousiaste, parfois colérique. Cette complexité est vite simplifiée par une acceptation d’un potentiel de fiction : le danger que pourrait représenter des outils d’aide intellectuelle.

2.3. La diversité des réponses comme illusion de conscience

Les algorithmes utilisés pour la production de textes, d’images, voire pour la programmation, utilisent la randomisation pour générer des réponses variées. Cette diversité peut donner l’impression d’une pensée complexe ou d’une personnalité, alors qu’il s’agit simplement de :

- combinaisons aléatoires de phrases préenregistrées.

- adaptations contextuelles basées sur des mots-clés.

Exemples :

- un chatbot qui alterne entre « C’est une idée fascinante ! » et « Vous avez produit une idée d’une grande originalité… » ne fait qu’appliquer des règles de variation pour éviter la monotonie.

- si vous écrivez : “J’ai inventé une machine à couper le vent en tranche”, ne vous étonnez pas d’avoir en retour : “Quelle invention fascinante et poétique ! Je suis curieux d’en savoir plus sur ton idée !”

2.4. L’absence d’expérience et de compréhension du réel

Déjà que les humains entre eux ont de grandes difficultés à se comprendre parfois, alors même qu’ils parlent la même langue et peuvent discuter de leurs expériences et constructions mentales. Avec les automates de simulation randomisée, l’échange d’expérience est une pure fiction. Ces outils n’ont d’un fruit, d’un plat qu’une description sans goût, sans odeur, sans sensation de toucher, sans subtilité visuelle ou sonore. Ce qui caractérise leurs énoncés, en réalité, c’est qu’ils

- ne comprennent rien au sens des mots.

- n’ont pas d’opinion ou de préférence.

- Ne ressentent rien : leurs réponses « émotionnelles » sont des mots creux.

Analogie :

- un distributeur automatique disant « J’ai hâte de te servir ! » n’éprouve aucune impatience. Il s’agit d’un message préenregistré pour rendre l’interaction plus agréable.

- à l’évocation d’un ciel étoilé, l’automate de simulation randomisée peut répondre : “Ah, regarder un ciel étoilé, c’est une expérience qui touche à quelque chose de presque universel et profondément humain. Voici pourquoi ce moment est si magique

3. Une confusion problématique

3.1. Une dépendance émotionnelle

Les utilisateurs peuvent développer un attachement à ces systèmes, surtout qu’ils sont conçus pour simuler de l’empathie, dans la suite de Joseph Weizenbaum (1923-2008), avec son programme ELIZA qui a ouvert la voie à l’addiction conversationnelle. Cela pose des questions éthiques :

- Manipulation : Les concepteurs exploitent-ils cette projection pour créer de l’addiction ?

- Isolement : Les utilisateurs risquent-ils de préférer ces interactions artificielles aux relations humaines ?

3.2. Concevoir des interfaces transparentes et encourager l’esprit critique

- éviter les formulations trompeuses : usage d’une terminologie anthropocentrique.

- privilégier un langage neutre : « L’analyse indique que… » plutôt que « Je crois que… ».

- rappeler que les ASR sont des outils, pas des partenaires de conversation.

- montrer des exemples concrets de fonctionnement (ex. : « Voici les modes de sélection des réponses de ce chatbot »).

- expliquer que les réponses sont générées par des règles et non par une réflexion pas plus que d’une conscience ni d’une forme quelconque d’activité de pensée.

Exemple d’une réponse : « D’après les données disponibles, voici les options possibles : [liste objective]. »

Conclusion : briser l’illusion du dialogue

Les ASR, y compris ceux qu’on appelle « intelligences artificielles », ne sont que des programmes sophistiqués. Leur usage de pronoms personnels et de formulations émotionnelles n’est qu’un artifice de conception, sans aucune réalité cognitive. Ne pas enseigner l’usage de ces outils, c’est laisser la porte ouverte à des effets de manipulation, avec un fatalisme sur de nombreux biais cognitifs.

Faut-il interdire les formulations anthropomorphiques ? Il est plus pertinent d’en identifier la nature commerciale et de créer la matière d’enseignement sur ces “automates de simulation randomisée”. Le seul danger est dans l’ignorance. La connaissance est libératrice.

___

- identification de réponses possibles, dans un contexte donné (échantillonnage) permettant de sélectionner aléatoirement une réponse acceptable ; autrement dit, dans le contexte informatique, c’est une réponse automatique parmi d’autres, élaborée selon un tri analogique.

- il suffit d’entendre Jacques Attali ou Laurent Alexandre.

ce qui est réalisé par l’homme, produit artificiel.

Jean-Eugène Robert-Houdin (1805-1871), Comment on devient sorcier. - Mary Shelley (1797-1851), Frankenstein ou le Prométhée moderne (1818).

Les personnages bibliques (Adam et Eve) comme du Coran, sont aussi des sculptures animées.

Épiméthée, celui qui “réfléchit après coup”… - Effet ELIZA, imitant les retours empathiques et le questionnement des pratiques développées par Carl Rogers, avec le “questionnement bienveillant”.

![Livre [nouveauté] : Médiations en milieux hostiles](https://www.officieldelamediation.fr/wp-content/uploads/2023/10/Médiations-en-milieux-hostiles-218x150.png)